KEEP GOING

[Spark] 스파크 버전 확인하기 본문

반응형

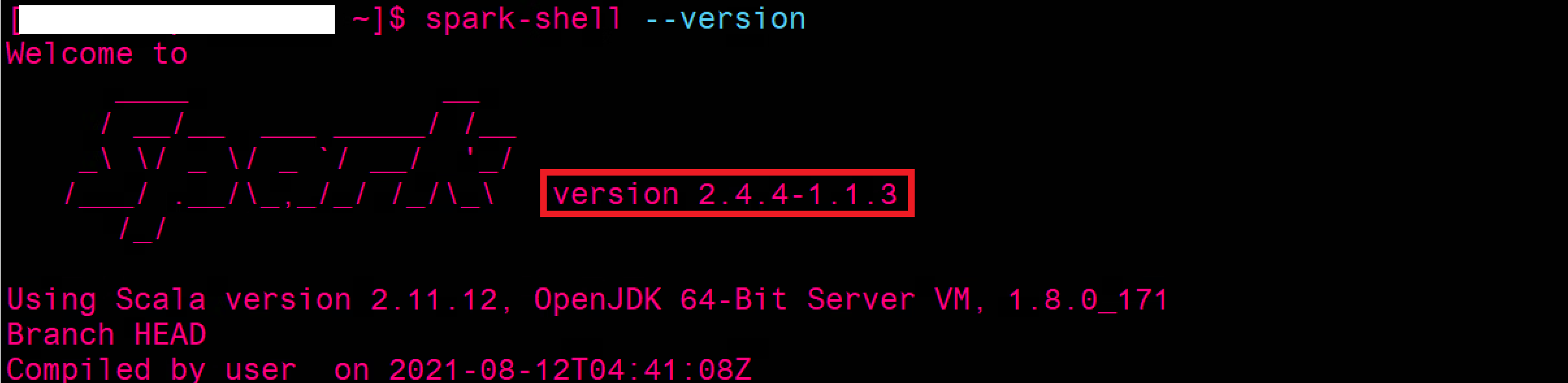

1. 커맨드 라인(CLI)에서 버전 확인

spark-submit --version

spark-shell --version

spark-sql --versionspark-submit: CLI에서 spark 프로그램을 실행하기 위한 명령어

spark-shell: CLI에서 스칼라를 이용하여 spark 처리시 사용하는 명령어

(pyspark: CLI에서 파이썬으로 saprk 처리시 사용하는 명령어)

spark-sql: CLI에서 Hive 쿼리 실행시 사용하는 명령어

세 명령어에 --version 옵션을 줘서 spark 버전을 확인할 수 있습니다.

spark-version으로 실행해보니 2.4.4 버전임을 알 수 있습니다.

동시에 scala 버전과 자바개발환경을 갖추기 위해 필요한 OpenJDK 버전도 확인 가능합니다.

나머지 방법(spark-submit. spark-sql)으로도 동일한 결과를 받아 볼 수 있습니다.

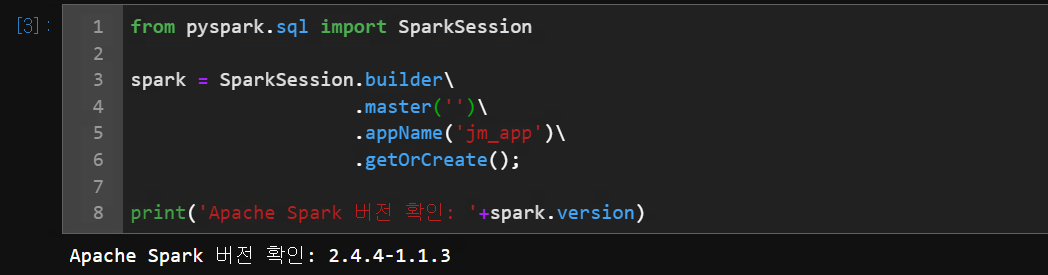

2. SparkSession 객체로 버전 확인

from pyspark.sql import SparkSession

spark = SparkSession.builder\

.master('')\

.appName('jm_app')\

.getOrCreate();

print('Apache Spark 버전 확인: '+spark.version)Hive에 sql로 접근하는데 필요한 SparkSession 객체를 통해서도 버전 확인이 가능합니다.

스파크 객체인 spark를 생성하여 .verson으로 버전을 확인할 수 있습니다.

반응형

'bigdata > spark' 카테고리의 다른 글

Comments